CSAM : le responsable de la confidentialité chez Apple interviewé

L’occasion de rassurer, une fois de plus.

Le CSAM est ce nouveau système en développement chez Apple et qui fait grand bruit en ce moment, puisqu’il a pour but de détecter les contenus pédopornographiques parmi les photos des utilisateurs d’iCloud Photos. Une FAQ a d’ailleurs été publiée par la firme californienne pour tenter de calmer les ardeurs des défenseurs de la vie privée, foire aux questions détaillées ici.

Pour tenter de mieux faire comprendre aux utilisateurs comment Apple compte à la fois respecter le caractère privé des photos et identifier une activité illégale de consultation de contenus pédopornographiques, Erik Neuenschwander, responsable de la confidentialité chez Apple, ou Head of Apple Privacy a répondu à plusieurs questions auprès de TechCrunch. Voici les points importants de l’interview, selon nous.

Une analyse côté appareil, au contraire d’autres services Cloud

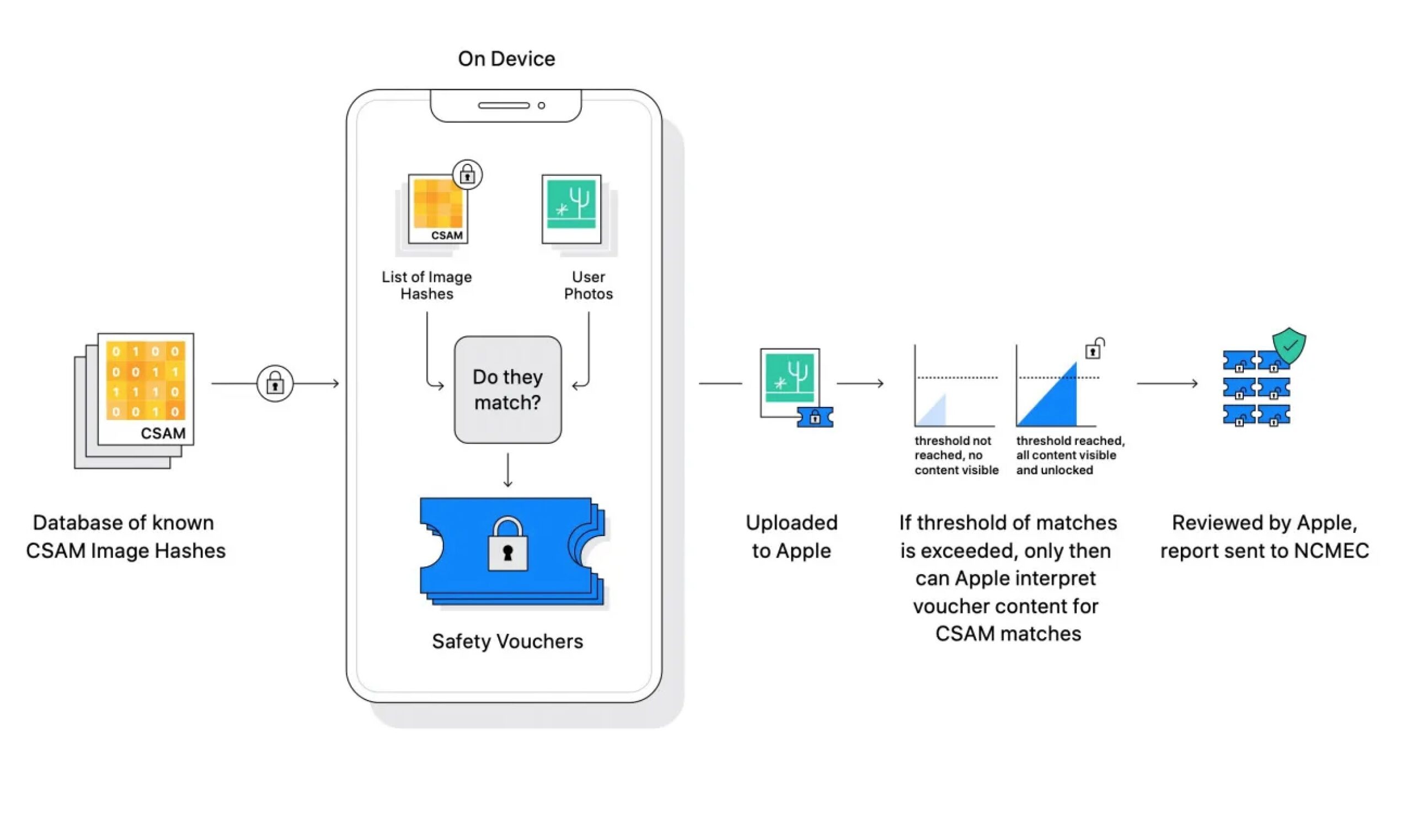

Erik Neuenschwander l’assure : le système d’Apple est différent d’autres systèmes Cloud pour la recherche de contenus pédopornographiques, puisque l’analyse de base se fait sur la machine de l’utilisateur et non dans le cloud. C’est une innovation technologique qui permet, toujours selon le responsable Apple, de recherche les images illégales tout en gardant le caractère confidentiel des données de l’utilisateur.

Comment ça marche ?

Le système créé en fait un identifiant pour une photo sensible, identifiant comparé avec ceux des photos des bases d’images pédopornographiques reconnues, comme celle du Center for Missing and Exploited Children.

Erik Neuenschwander l’assure, le système ne peut jamais accéder aux données de l’iPhone ou encore à l’entière photothèque iCloud de l’utilisateur.

© AppleEn outre, à partir du moment ou un certain nombre d’images sensibles ont été identifiées comme identiques à des images des bases de données servant à la comparaison, l’alerte est donnée. Il y a donc un certain seul à dépasser. Cela permet, entre autres, de servir de première limitation à l’apparition de faux positifs. Mais ce seuil rend aussi impossible la recherche d’une unique image à l’intérieur d’un compte iCloud Photos. Enfin, il empêche la recherche d’autres images que celles initialement ciblées pour lutter contre la pédopornographie.

Le CSAM exclusif à iCloud et aux USA

Au départ, le système sera exclusif aux utilisateurs américains et touchera uniquement les photos téléchargées sur iCloud. Comme indiqué par MacRumors, il ne serait pas impossible qu’un déploiement à l’étranger soit de mise dans un second temps. Mais cela va dépendre de chaque pays visé et de la dureté de sa légalisation en matière de confidentialité et de pédopornographie.

La détection d’image sera en tout cas mise en route après la sortie des nouveaux OS iOS 15, macOS Monterey et iPadOS 15. Rappelons qu’Apple n’est pas le premier acteur tech à mettre en place un tel système pour lutter contre la photographie pédopornographique. Google, via l’outil CyberTipline, peut être alerté en cas de partage de photos pédopornographiques par un utilisateur de Gmail.

Que pensez-vous de ce nouveau système CSAM d’Apple pour repérer les contenus pédopornographiques sur iCloud ?

Ezeta

13 août 2021 à 8 h 12 min

Je pense que c’est bien.

En France on est trop parano sur les question de confidentialité (alors qu’il n’y a des plus grand chose de confidentiel) ou éthique au détriment de tout autre aspect vital ou moral.

Ranonym4All

13 août 2021 à 9 h 57 min

| En France on est trop parano sur les question de confidentialité

Tu répondras ça aux policiers, quand on t’arrêtera car tu as pris en photos ton enfant à la plage. Il y a une grande différence entre vie privé et espionnage et une encore plus grande entre surveillé et fliqué.

Pierre Otin

13 août 2021 à 10 h 06 min

@Ranonym4All : lisez bien sur le sujet, il n’est nullement question de surveiller les gens qui prennent leurs propres enfants en photo, même nus. Il s’agit de détecter les utilisateurs partageant des contenus déjà identifiés comme étant de la pédopornographie par les organisations de protection de l’enfance.

User1473362460237 (posté avec l'app i-nfo.fr V2)

13 août 2021 à 10 h 18 min

@Pierre_Otin l’outil est capable de reconnaître une image d’un enfant nu grâce à une banque d’image donc si je pense que beaucoup de personnes qui ont pris des photos familiales peuvent s’en soucier…

Darth Philou

13 août 2021 à 10 h 25 min

Non ! La comparaison est réalisée sur des images déjà identifiées. Relisez et renseignez-vous sur ce qu’est le CSAM.

Lecteur-1604530471 (posté avec l'app i-nfo.fr V2)

7 septembre 2021 à 10 h 36 min

Le haut de la pyramide et les dirigeant du système craignent d’être victime de leur propre politique